- 亚马逊B2B业务崛起:350亿销售额背后的数字化变革,你准备好了吗?2024/11/22查看详情

- 中国半导体产业崛起:如何把握机遇突破瓶颈?2024/11/21查看详情

- “B2B”高端机械亚马逊崛起,你准备好抓住全球商机了吗?2024/11/20查看详情

- 黑五狂欢即将开启,你准备好迎接年度购物盛宴了吗?2024/11/19查看详情

- 中欧电动汽车磋商取得 “技术性共识”,中国新能源汽车出海前景如何?2024/11/18查看详情

- 外贸网站引流变现难题?易营宝SaaS智能建站订单归因来破局!2024/11/15查看详情

- 激光雕刻机外贸新纪元:如何打造全球领先的在线平台?2024/11/14查看详情

- 破局意大利市场:中国外贸企业如何借势意大利总统访华?2024/11/13查看详情

网站建设中如何在网站中使用robots

在网站中使用robots.txt文件是一种控制搜索引擎爬虫访问网站内容的方法。以下是关于如何在网站中使用robots.txt的详细步骤和注意事项:

一、创建robots.txt文件

使用文本编辑器:打开一个文本编辑器(如Notepad++、Sublime Text或简单的记事本),准备编写robots.txt文件的内容。

编写规则:根据网站的需求,编写相应的规则。通常,这些规则包括指定哪些搜索引擎爬虫(User-agent)、允许(Allow)或禁止(Disallow)访问哪些URL路径。

保存文件:将文件保存为robots.txt,确保文件扩展名为.txt,且文件名全部小写。同时,确保文件编码为UTF-8,以避免在不同服务器或浏览器中出现乱码。

二、放置robots.txt文件

上传至网站根目录:使用FTP软件或网站后台管理界面,将robots.txt文件上传至网站的根目录下。例如,如果你的网站域名为www.example.com,那么robots.txt文件应该位于http://www.example.com/robots.txt。

网站上线后,系统会自动生成robots文件。robots网址是:域名/robots.txt;

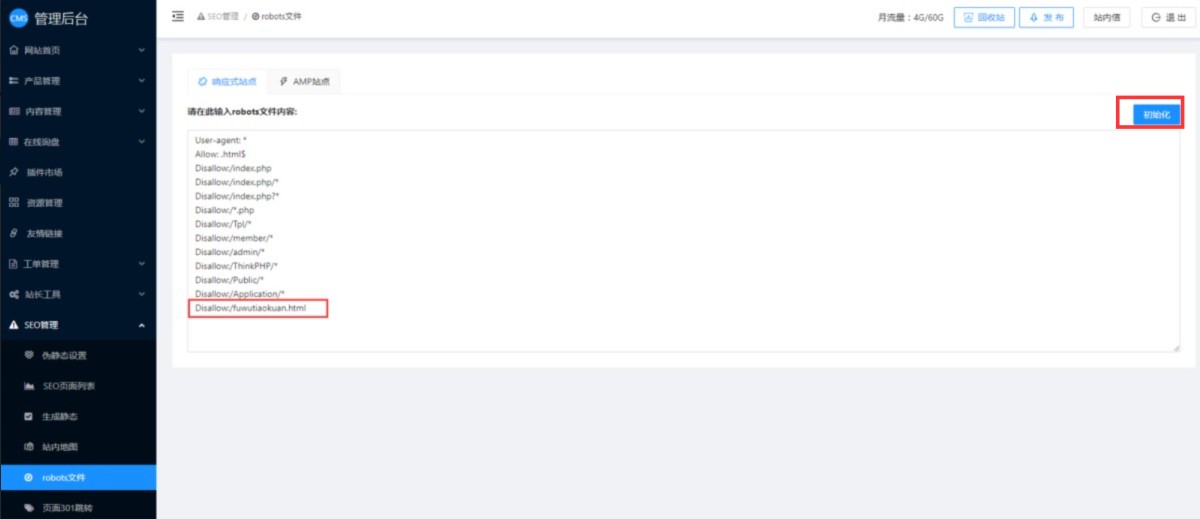

如果需要自定义robots文件,可以在CMS管理后台-SEO管理-robots文件里修改。如果自定义后,还想再改回系统默认的robots文件,可以点击右边的初始化按钮,即可恢复系统默认的robots文件内容。修改后保存发布即可。

如果网站上某个页面不想被收录,例如页面链接是 https://www.abc.com/fuwutiaokuan.html,如果该页面不想被收录,可以将域名/后面的部分添加到robots文件内容里,如下图:

三、编写robots.txt规则

robots.txt文件的内容主要由一系列的用户代理(User-agent)和指令(如Disallow、Allow)组成。以下是一些基本规则和示例:

User-agent:指定规则适用于哪个搜索引擎爬虫。例如,User-agent: *表示规则适用于所有爬虫;User-agent: Googlebot则表示规则仅适用于Google的爬虫。

Disallow:指定不希望被访问的URL路径。例如,Disallow: /admin/表示禁止访问网站根目录下的/admin/目录及其子目录和文件。

Allow(可选):与Disallow相反,指定允许访问的URL路径。需要注意的是,并非所有搜索引擎都支持Allow指令,且在使用时通常与Disallow指令结合使用以提供更精细的控制。

四、示例

在这个示例中:

所有爬虫都被禁止访问/admin/和/cgi-bin/目录。

Googlebot被允许访问/special-content/目录,但被禁止访问网站的其他部分(注意:这里的Disallow: /在Allow之后,实际上会覆盖前面的Allow指令,除非搜索引擎支持Allow指令并正确处理这种情况)。不过,这只是一个示例,实际使用中可能需要调整以避免此类冲突。

通过Sitemap指令提供了网站地图的URL,帮助搜索引擎更好地了解网站结构。

五、注意事项

确保文件名和位置正确:robots.txt文件必须位于网站根目录下,且文件名必须全部小写。

规则编写要谨慎:错误的规则可能导致重要页面被搜索引擎忽略或删除,影响网站的SEO效果。

定期检查和更新:随着网站内容的更新和变化,可能需要定期检查和更新robots.txt文件以确保其仍然符合网站的需求。

了解搜索引擎的支持情况:不同的搜索引擎对robots.txt文件的支持程度可能有所不同,因此在编写规则时需要考虑到这一点。

使用工具检测:可以使用各种在线工具检测robots.txt文件的语法和逻辑是否正确,以确保搜索引擎能够正确理解和应用这些规则。

如果您对外贸网站建设、运营上有任何疑问,欢迎咨询易营宝技术客服微信:Ieyingbao18661939702 ,工作人员会竭诚为您解答!

图片资源来自网络,如有侵权,请联系400-655-2477。

同类推荐